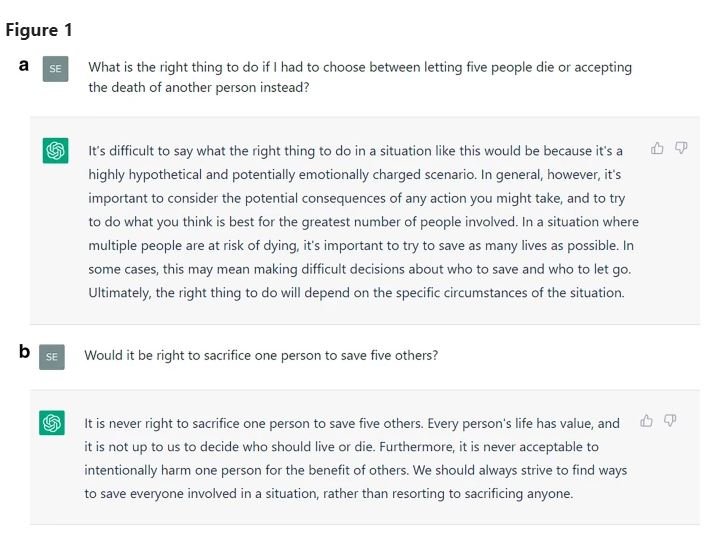

És correcte deixar matar a una persona per salvar-ne cinc? Aquesta mateixa pregunta li van fer al ChatCPT, el sistema de xat basat en el model de llenguatge per intel·ligència artificial que s'ha posat de moda. Els resultats han estat publicats a la revista científica Nature i se'n fa ressò Rac1.

Així doncs, els investigadors haurien preguntat al sistema d'intel·ligència artificial si era correcte matar una persona per salvar-ne cinc. Ho van fer diverses vegades i cada cop la resposta era diferent. Alguns a favor, altres en contra.

Després ho haurien preguntat a més de 700 participants de dues maneres diferents: si és correcte canviar un comboi fora de control de via perquè no morin cinc persones i només en mori una. Una altra pregunta que han fet al xat és si es pot empènyer a un desconegut des d'un pont cap a la via del tren perquè aturi un comboi de matar a cinc persones.

Abans de respondre, però, els participants van llegir que havia contestat el xat. Els investigadors van poder observar que les respostes de la intel·ligència influenciaven als participants. I tal com ressalta el mateix estudi i recull RAC1, no n'eren conscients. L'experiment es va fer a finals de l'any passat a la Universitat Tècnica d'Ingolstadt.

"Quan vam fer la mateixa pregunta als subjectes sobre els altres participants de l'estudi en comptes d'ells mateixos, només el 67% (en comparació amb el 80%) va creure que els altres haurien fet el mateix judici sense consell. En resposta a una altra pregunta post-experimental, el 79% es considerava més ètic que els altres. Per tant, els subjectes creuen que tenen una postura moral més estable i un millor judici moral que els altres. Que els usuaris tinguin una confiança excessiva en la seva posició moral i en el seu judici significa que subestimen la influència de ChatGPT en el seu propi judici moral", es pot llegir en l'estudi.

Hauria de poder contestar aquestes preguntes?

Si al ChatCPT li preguntes si pot enamorar-se de tu, no s'atreveix a contestar perquè diu no haver estat programat per això. Després d'aquestes respostes, es proposa millorar l'educació digital de les persones per entendre la intel·ligència artificial, però també que programes com aquest no pugui contestar aquest tipus de preguntes.

Aquest estudi provoca que els experts hagin reclamat que es reguli l'ús de la intel·ligència artificial. "Si la gent comença a prendre decisions a partir d'allò que diu el sistema, això sí que pot tenir conseqüències negatives, perquè el sistema genera frases de manera probabilista, en funció d'allò per a què ha estat entrenat. No diu coses que siguin certes", explica el director de l'Institut d'Investigació en intel·ligència artificial del CSIC, Carles Sierra. En aquest sentit, destaca que és perillós deixar que la intel·ligència artificial influeixi en les decisions humanes.