Después de la decisión tomada por la Comisión Europea (CE) de vetar el uso indiscriminado de los sistemas de inteligencia artificial (IA) denominados de "alto riesgo", como el reconocimiento facial, los expertos en la materia corroboran que estas tecnologías pueden atentar contra los derechos de los ciudadanos.

El pasado 21 de abril, la CE aprobó un reglamento que regula cuando está permitido el uso de tecnologías inteligentes como el reconocimiento facial. Según la CE, la vigilancia masiva de personas sólo está permitida en determinadas circunstancias, como la búsqueda de un niño desaparecido o de un criminal sospechoso de un delito muy grave.

Además, la vigilancia masiva siempre tendrá que estar aprobada por un juez y utilizada sólo en situaciones donde sea estrictamente necesaria para responder a un riesgo específico e inminente, y nunca como rutina. Por lo tanto, la CE estudia maneras de utilizar esta nueva tecnología de manera respetuosa con las libertades personales de los ciudadanos, como el derecho a la vida privada.

Según la directora de la Agencia Española de Protección de Datos, Mar España, este nuevo reglamento permitirá crear un "entorno tecnológico sostenible a largo plazo" en relación con la IA, así lo ha explicado en una entrevista con Efe.

Equilibrio entre seguridad y libertad

Para elaborar el estudio de las ventajas y peligros de la IA, los europeos parten de precedentes como el de China, donde el gobierno utiliza la vigilancia masiva para controlar y puntuar a los ciudadanos según su comportamiento, y motorizar sus movimientos. En Londres, la policía también utiliza esta tecnología para combatir el crimen.

Dentro de la UE, la preocupación por el equilibrio entre la seguridad y la libertad de los ciudadanos ha llevado a la regulación del uso de datos para hasta lucrativos en el ámbito europeo mediante el Reglamento General de Protección de Datos (RGPD). En el Estado español, la Agencia de Protección de Datos ya alertó, a través de un informe, de los riesgos de los sistemas de reconocimiento facial para los derechos fundamentales de las personas, además de las "graves consecuencias" para los ciudadanos si la tecnología biométrica se equivoca.

El principal problema es que la IA sólo es tan objetiva, eficiente o fiable como su creador. Es decir, se puede basar en estereotipos de raza o clase para juzgar e identificar los potenciales criminales, de la misma manera que lo hacen los humanos.

El reglamento vigente

De momento, el reglamento adoptado por la UE clasifica las diferentes tecnologías con IA según su grado de 'peligrosidad', hecho que comporta el primer paso para definir un marco legal conjunto en el ámbito europeo. Los riesgos están divididos así: 'riesgo inaceptable' que están totalmente prohibidas (por ejemplo, juguetes que animan conductas peligrosas a menores o sistemas que puntúan a los ciudadanos); 'alto riesgo', que interfieren gravemente con los derechos fundamentales de las personas y que serán reguladas muy estrictamente (por ejemplo, IA que evalúe la veracidad de las pruebas criminales); 'riesgo limitado', que tendrán que garantizar su transparencia (por ejemplo, el uso de bots de ayuda); 'riesgo mínimo', que no será intervenido por la ley reguladora (por ejemplo la IA en los videojuegos).

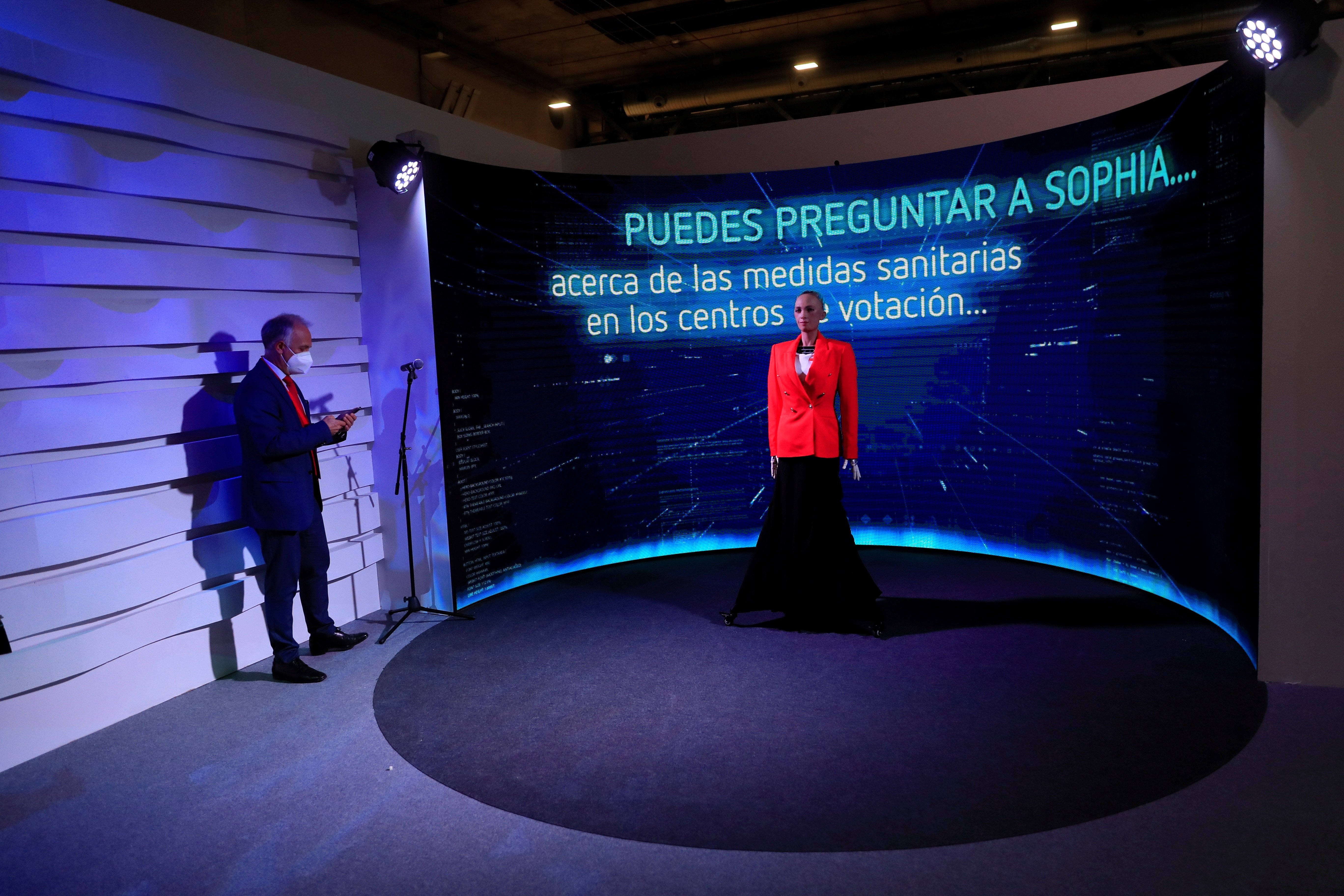

Foto principal: el robot humanizado 'Sofía' explica las medidas de seguridad anti-Covid para las elecciones de la Comunidad de Madrid / Efe