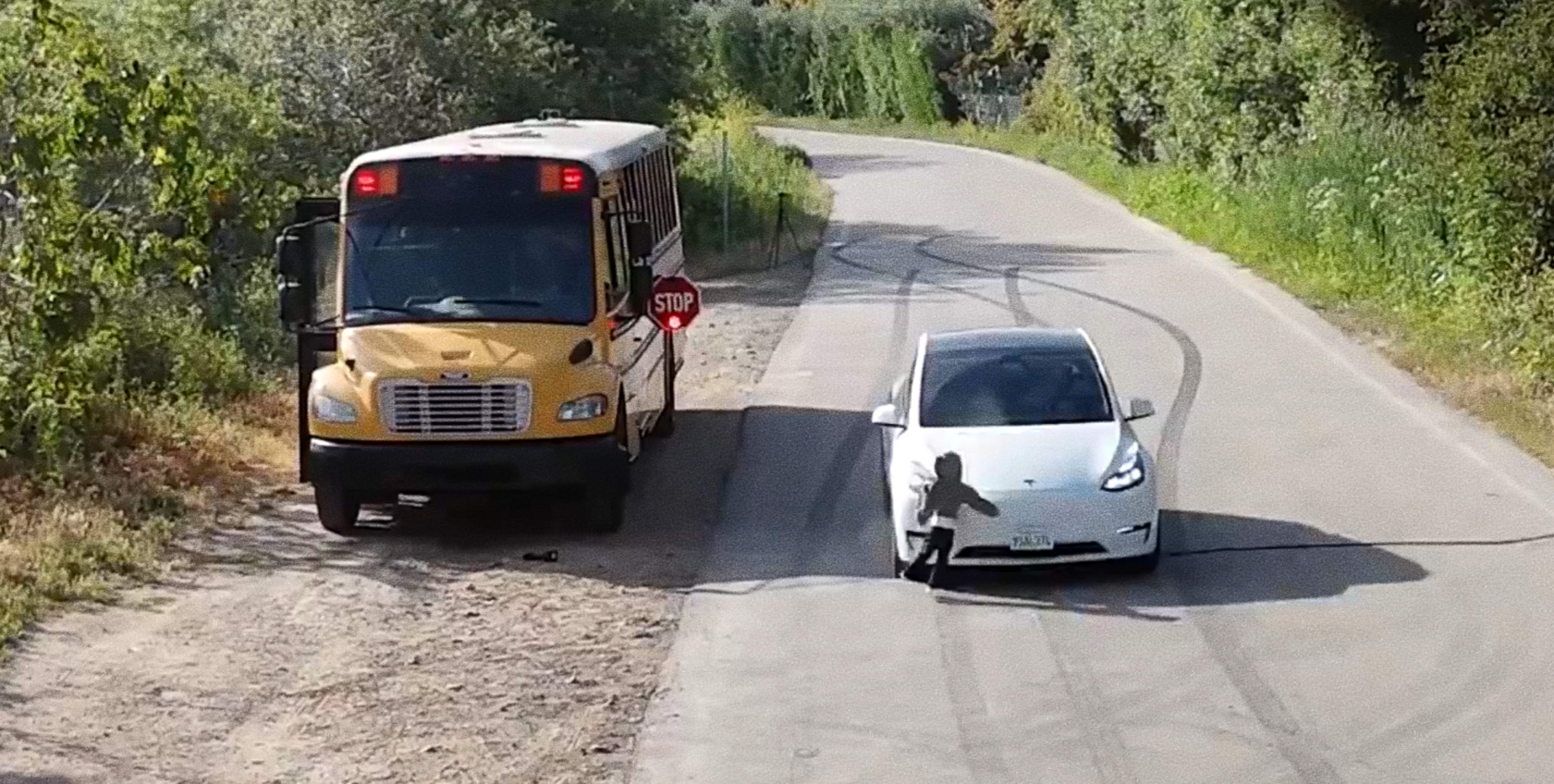

Tesla ha tornat a deixar-nos una notícia cridanera, encara que no per revolucionar la mobilitat, sinó pel seu aspecte més negatiu. Un vídeo que s'ha convertit en viral ens mostra com un Tesla Model Y, equipat amb l'última versió del seu programari de conducció autònoma, no frena davant d'un maniquí infantil que creua per davant d'un autobús escolar detingut. El sistema detecta la figura com un vianant, però no redueix la velocitat ni pren mesures per evitar l'impacte.

Tesla atropella un maniquí infantil que havia estat detectat com a vianant

Si vols motius per discutir sobre la viabilitat dels sistemes de conducció autònoma, aquest test de seguretat, dut a terme en condicions controlades, però simulant una situació real de trànsit escolar, ha tornat a reobrir un debat que sembla que encara no estava tancat. Pot el programari de Tesla prendre decisions correctes fins i tot quan és conscient dels perills de la carretera?

L'escena ha estat gravada en vídeo, ho pots veure sota aquestes línies, i va ser publicada per l'enginyer Dan O'Dowd, fundador de The Dawn Project. Tal com ells mateixos ho defineixen, l'objectiu és "és utilitzar la Metodologia de l'Alba per portar programari de la foscor de la nit a la llum del dia". I és que Dan és un crític declarat del sistema de conducció autònoma de Tesla.

Tesla FSD 13.2.9 will still run a kid down while illegally blowing past a stopped school bus with red lights flashing and stop sign extended. Elon Musk how many kids does FSD need to run over before you fix this? I warned about this danger at the 2023 Super Bowl!

— Dan O'Dowd (@realdanodowd.bsky.social) 28 de maig de 2025, 16:17

[image or embed]

Ja el 2023, per parlar d'incidents similars, un estudiant de secundària a Carolina del Nord, Tillman Mitchell, va ser atropellat per un Model Y després de baixar d'un autobús escolar. Va patir ferides greus, incloent-hi una fractura de coll i una cama trencada. Les autoritats sospiten que el cotxe tenia actiu l'Autopilot o el FSD, el sistema de conducció autònoma, en el moment de l'accident. En ambdós casos, el patró és el mateix: el sistema no és cec. Reconeix el vianant, però no reacciona.

El preocupant no és només un error de percepció, sinó la falta de presa de decisions. Podem dir que un cotxe és segur quan veu un nen creuant i decideix seguir el seu camí sense frenar? Malgrat aquests errors, Elon Musk ja ha anunciat que desplegaran una petita flota de robotaxis a Austin, Texas, en les pròximes setmanes. No seran els futuristes Cybercab, sinó models estàndard del Model Y operant amb el programari FSD.

El desplegament serà limitat a zones més fàcils de navegar mitjançant geotanques i cada vehicle serà monitorat de forma remota. El CEO de Tesla assegura que les proves actuals a Austin mostren gairebé cap intervenció humana, encara que els crítics responen que una taxa d'errors baixa no és suficient quan es tracta de decisions que poden costar vides.

De moment, ni Tesla ni Elon Musk no han emprès accions legals contra DanO'Dowd o The Dawn Project, malgrat la duresa de les seves demostracions. Tampoc no ho van fer quan el popular divulgador Mark Rober, exenginyer de la NASA, va mostrar com un Tesla s'encastava contra una paret d'escuma amb una carretera pintada. Ara, sembla que la mobilitat del futur necessita una mica més que promeses: necessita frenar a temps.