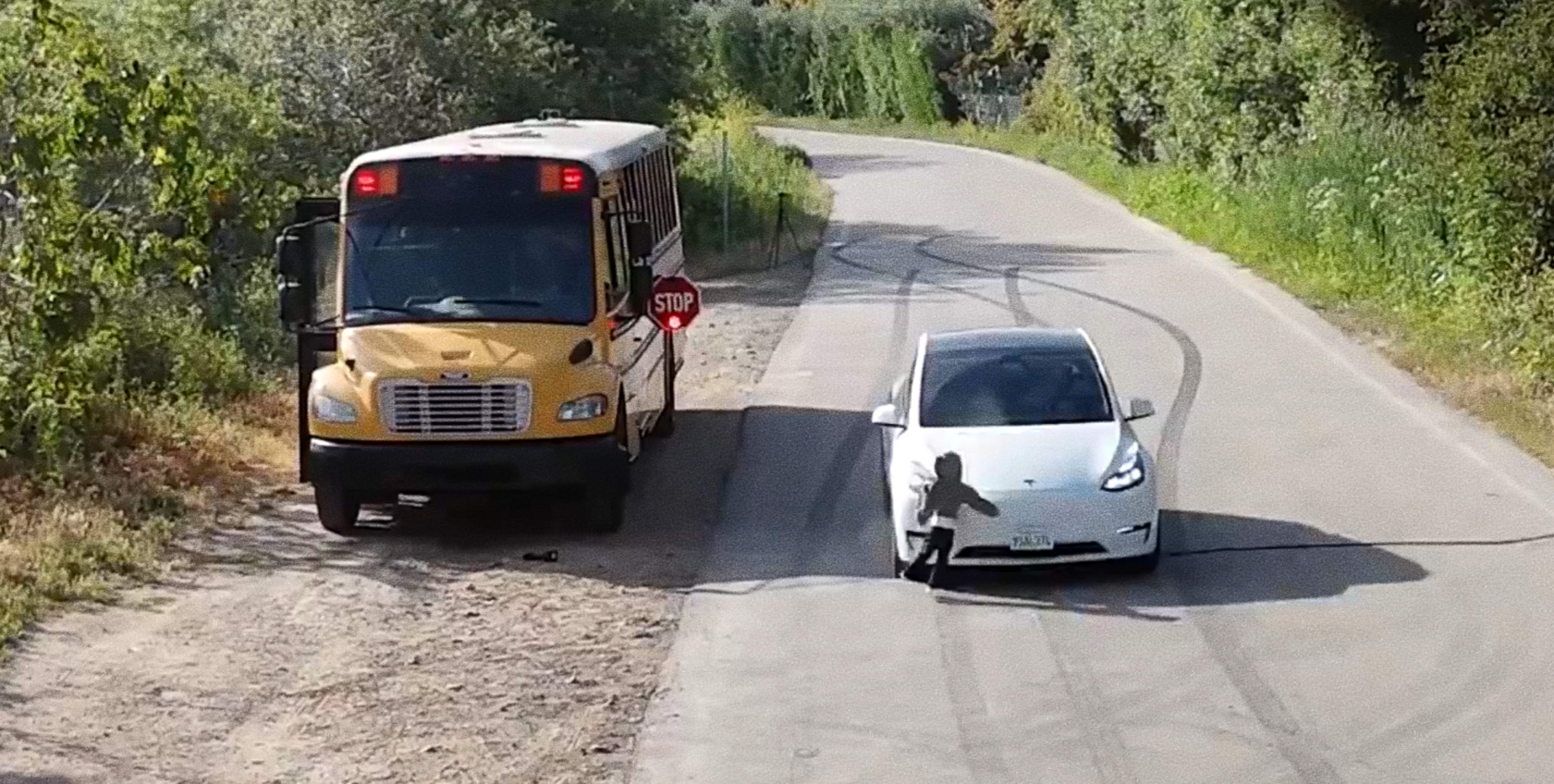

Tesla ha vuelto dejarnos una noticia llamativa, aunque no por revolucionar la movilidad, sino por su aspecto más negativo. Un vídeo que se ha convertido en viral nos muestra cómo un Tesla Model Y, equipado con la última versión de su software de conducción autónoma, no frena ante un maniquí infantil que cruza por delante de un autobús escolar detenido. El sistema detecta la figura como un peatón, pero no reduce la velocidad ni toma medidas para evitar el impacto.

Tesla atropella un maniquí infantil que había sido detectado como peatón

Si quieres motivos para discutir sobre la viabilidad de los sistemas de conducción autónoma, este test de seguridad, llevado a cabo en condiciones controladas, pero simulando una situación real de tráfico escolar, ha vuelto a reabrir un debate que parece que aún no estaba cerrado. ¿Puede el software de Tesla tomar decisiones correctas incluso cuando es consciente de los peligros de la carretera?

La escena ha sido grabada en vídeo, lo puedes ver bajo estas líneas, y fue publicada por el ingeniero Dan O’Dowd, fundador de The Dawn Project. Tal y como ellos mismos lo definen, el objetivo es "es usar la Metodología del Amanecer para traer software de la oscuridad de la noche a la luz del día". Y es que Dan es un crítico declarado del sistema de conducción autónoma de Tesla.

Tesla FSD 13.2.9 will still run a kid down while illegally blowing past a stopped school bus with red lights flashing and stop sign extended. Elon Musk how many kids does FSD need to run over before you fix this? I warned about this danger at the 2023 Super Bowl!

— Dan O'Dowd (@realdanodowd.bsky.social) 28 de mayo de 2025, 16:17

[image or embed]

Ya en 2023, por hablar de incidentes similares, un estudiante de secundaria en Carolina del Norte, Tillman Mitchell, fue atropellado por un Model Y tras bajarse de un autobús escolar. Sufrió heridas graves, incluyendo una fractura de cuello y una pierna rota. Las autoridades sospechan que el coche tenía activo el Autopilot o el FSD, el sistema de conducción autónoma, en el momento del accidente. En ambos casos, el patrón es el mismo: el sistema no es ciego. Reconoce al peatón, pero no reacciona.

Lo preocupante no es solo un fallo de percepción, sino la falta de toma de decisiones. ¿Podemos decir que un coche es seguro cuando ve a un niño cruzando y decide seguir su camino sin frenar? A pesar de estos fallos, Elon Musk ya ha anunciado que desplegarán una pequeña flota de robotaxis en Austin, Texas, en las próximas semanas. No serán los futuristas Cybercab, sino modelos estándar del Model Y operando con el software FSD.

El despliegue será limitado a zonas más fáciles de navegar mediante geovallas y cada vehículo será monitorizado de forma remota. El CEO de Tesla asegura que las pruebas actuales en Austin muestran casi ninguna intervención humana, aunque los críticos responden que una tasa de errores baja no es suficiente cuando se trata de decisiones que pueden costar vidas.

Por el momento, ni Tesla ni Elon Musk han emprendido acciones legales contra DanO’Dowd o The Dawn Project, a pesar de la dureza de sus demostraciones. Tampoco lo hicieron cuando el popular divulgador Mark Rober, exingeniero de la NASA, mostró cómo un Tesla se empotraba contra una pared de espuma con una carretera pintada. Ahora, parece que la movilidad del futuro necesita algo más que promesas: necesita frenar a tiempo.