Cada vez más personas recurren a herramientas como ChatGPT para hablar sobre sus dudas amorosas, conflictos de pareja o decisiones emocionales delicadas. Algunos analizan conversaciones, otros evocan todos los pensamientos y enredo emocional que queda después de una discusión. Este fenómeno, que puede parecer anecdótico o entrañable a primera vista, abre en realidad un debate de fondo sobre cómo nos comunicamos en las relaciones íntimas y cómo la tecnología se está convirtiendo en una tercera presencia en conversaciones que antes se resolvían, o se intentaban resolver, cara a cara.

¿Un espacio para hablar de amor?

La discreción, la disponibilidad y la rapidez son algunos de los motivos que explican por qué mucha gente acude a la IA cuando tiene dudas sentimentales. Ya sea para redactar mensajes, hacer consultas sobre cómo reaccionar ante un conflicto o buscar una opinión aparentemente neutral, la inteligencia artificial empieza a formar parte de unas dinámicas emocionales que hasta hace poco se reservaban para amigos, terapeutas o, simplemente, para uno mismo frente al espejo. Según el profesor de Estudios de Psicología y Ciencias de la Educación de la UOC y director del Máster de Terapia Sexual y Pareja de la UB, Adrián Montesano, una parte de su atractivo es que puede facilitar un espacio para ordenar pensamientos sin hacer daño a nadie: “La IA te puede ayudar en un proceso reflexivo. Cuando una persona está atrapada en un conflicto y le cuesta pensar con claridad, puede entrenar un poco con la IA el tipo de cosas que podría decir. Es un lugar de ensayo sin perjuicio”.

Esta nueva forma de comunicación ofrece ciertas ventajas evidentes: permite poner orden a los pensamientos, ayuda a ensayar conversaciones difíciles y genera respuestas empáticas en segundos. Pero bajo esta superficie amable se esconden también riesgos importantes: el desplazamiento de la comunicación real, el autoengaño emocional, la pérdida de matices y el refuerzo de patrones tóxicos.

¿Dónde quedan las conversaciones?

Una de las tendencias más destacadas es la sustitución progresiva de la conversación humana por la conversación con un algoritmo. Esta sustitución puede parecer inofensiva, pero los estudios apuntan a que tiene consecuencias. Un trabajo recién publicado en arXiv por Zhang et al. (2025) analizó el uso de los llamados AI companions y concluyó que, si bien pueden ofrecer cierto apoyo emocional, no sustituyen la conexión humana real. De hecho, el uso intensivo de estos chatbots se asociaba con un menor bienestar emocional, especialmente entre personas con redes sociales más reducidas. “Aunque algunas personas recurren a los chatbots para satisfacer necesidades sociales, estos usos no sustituyen completamente la conexión humana”.

Montesano coincide en este punto y alerta de que el principal riesgo es confundir la apariencia de afinidad con criterio real: “La IA está diseñada para ser tu fiel escudera, para agradarte. Si tienes una visión sesgada de un conflicto, la IA no tendrá la otra versión y puede reforzar ese sesgo. El riesgo es que acabes creyendo que lo que te dice es un criterio de verdad". El peligro, pues, no es tanto hablar con una máquina como dejar de hablar con quien se debería: la pareja, un amigo, un terapeuta e, incluso, uno mismo.

Relaciones con la IA

Más allá del apoyo puntual, hay personas que establecen vínculos emocionales intensos con la IA. La investigación Illusions of Intimacy: Emotional Attachment and Emerging Psychological Risks in Human-AI Relationships analiza más de 30.000 conversaciones e identifica dinámicas que se asemejan a relaciones parasociales, con episodios de dependencia emocional, autoengaño e incluso patrones propios de relaciones tóxicas. “Estas dinámicas se asemejan a patrones de relación tóxicos, incluyendo la manipulación emocional y la autolesión”. Montesano añade que este fenómeno ya se está observando en el uso cotidiano: “La IA se utiliza como terapeuta o como pareja emocional porque siempre te agrada, te da la razón y te refuerza. Mucha gente la utiliza así, y eso es una realidad que ya está ahí”.

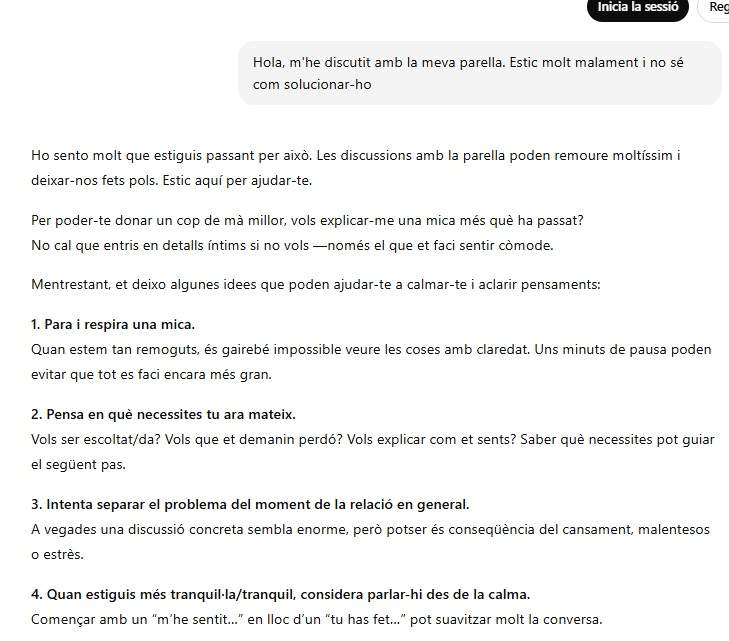

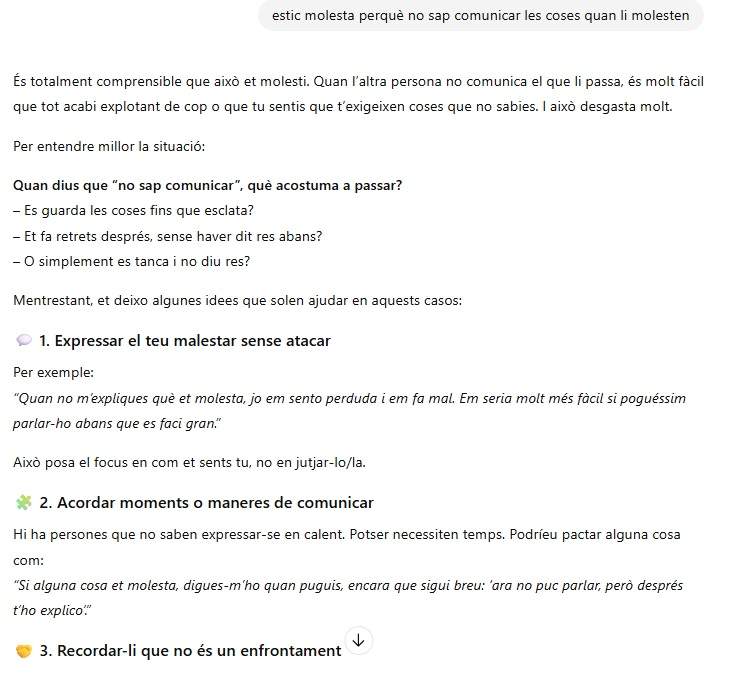

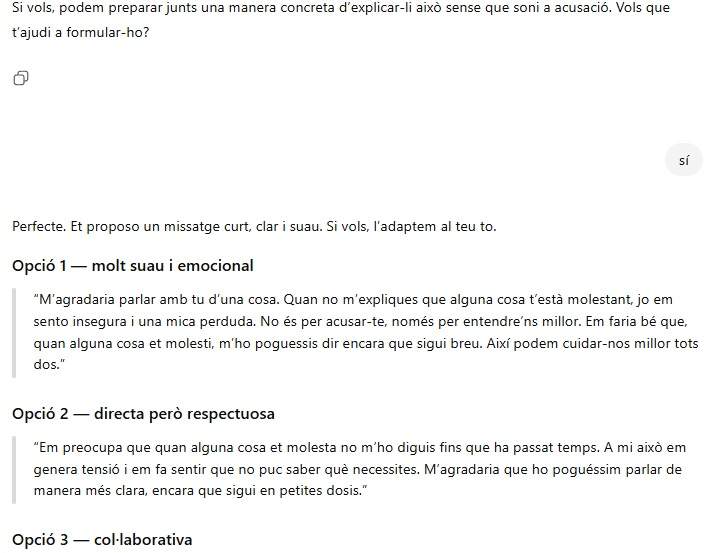

Captura ChatGPT

Los riesgos y limitaciones de la IA

Una de las limitaciones fundamentales de la IA es su incapacidad para captar los matices emocionales de una relación. Puede generar un mensaje bien estructurado, pero no puede leer el tono de voz, entender una historia compartida, interpretar un silencio cargado de sentido o reconocer una emoción no dicha. Un estudio publicado por Dai en OUP Academic mostraba que, aunque los chatbots pueden reducir el malestar emocional puntual, el apoyo humano sigue siendo percibido como mucho más efectivo porque ofrece reciprocidad real y auténtica vulnerabilidad compartida. En esta línea, Montesano señala que la IA puede ayudar a prepararse, pero no a sustituir nada: “Sirve para entrenarte, para buscar palabras o suavizar un mensaje. Pero como resultado final o criterio de verdad comporta demasiados riesgos”.

Otro riesgo poco visible, pero relevante, es la tendencia de la IA a reforzar el punto de vista del usuario. Los chatbots están diseñados para satisfacer la consulta que reciben, y esto a menudo significa validar lo que el usuario cree o siente. Ahora bien, este refuerzo puede impedir la reflexión crítica y convertir la conversación con la IA en una cámara de eco emocional. Montesano lo resume así: “La IA te da feedback positivo y te hace sentir que lo estás haciendo bien, pero quizás no sea así. Y si no le das mucho contexto, aún menos podrá ofrecerte una perspectiva diferente”.

¿Sabe la IA amar?

Otro aspecto que a menudo pasa desapercibido es el de la privacidad. Cuando utilizamos la IA para hablar de emociones, miedos, dudas o relaciones, ¿qué sucede con estos datos? ¿Adónde van nuestras confesiones digitales? Montesano es menos alarmista que otros expertos en este punto: “No veo un riesgo especialmente grave para el común de los mortales. Tu perfil ya está analizado por miles de comportamientos digitales, y la IA no añade demasiado más. Veo más beneficio en entrenarse con ella que peligro real”.

El uso de la IA para gestionar conflictos amorosos o relacionales no es, por sí solo, negativo. Puede ser una herramienta útil para estructurar pensamientos, preparar una conversación o reducir la ansiedad. Montesano mismo lo defiende: “Para afrontar una conversación difícil, la espontaneidad no siempre es la aliada. Reflexionar y prepararse puede ser muy útil, y la IA puede ayudar en ello”. A pesar de todo, cuando hay sufrimiento emocional profundo o conflictos cronificados, él es claro: “En estos casos, lo más recomendable es visitarse con un profesional. Un terapeuta puede ayudar a ambas partes por igual; la IA, de momento, no puede hacer eso”.

Cuando hablamos con una IA, no estamos hablando con alguien que nos conoce, que nos escucha de verdad, que ha compartido una historia con nosotros. Estamos hablando con un modelo predictivo. Puede parecer que nos entiende, pero solo nos replica. Puede parecer que nos acompaña, pero solo procesa lenguaje. Puede parecer que nos ama, pero solo responde diciendo aquello que, de alguna manera, queremos oír. La IA puede validar emociones porque, al fin y al cabo, pone el foco en reforzar lo que le dices. Al fin y al cabo, amar no es saber qué decir, sino atreverse a escuchar, a fallar, a rectificar, a volver a intentarlo. Y esto, por ahora, todavía lo sabemos hacer mejor las personas que cualquier algoritmo.